学术中心

一种新的植株尺度多传感器融合方法:从2D到3D

发布时间:

2024-06-23

来源:

作者:

非侵入性作物表型分析对于依赖图像处理技术的作物建模至关重要。本研究提出了一种植物尺度视觉系统,可以获取农业领域的多光谱植物数据。本文提出了一种使用三台相机、两台多光谱相机和一台RGB深度相机的传感器融合方法。传感器融合方法应用模式识别和统计优化来生成单个多光谱3D图像,该图像结合了作物的热图像和近红外图像。多相机传感器融合方法包含五个多光谱波段:三个来自可见光范围,两个来自不可见光范围(即近红外和中红外)。物体识别方法检查每个图像中的大约7000个特征,并且在校准期间只运行一次。感官融合过程的结果是一个单图形转换模型,该模型将多光谱和RGB数据集成到连贯的3D表示中。这种方法可以处理遮挡,从而可以准确地提取作物特征。结果是一个3D点云,其中包含最初在2D中分别获得的热和近红外多光谱数据。

图1 a全光相机、多光谱相机和热像仪的机械组件,b Kinect V2、多光谱相机和热像仪的机械组装。

图1 a全光相机、多光谱相机和热像仪的机械组件,b Kinect V2、多光谱相机和热像仪的机械组装。

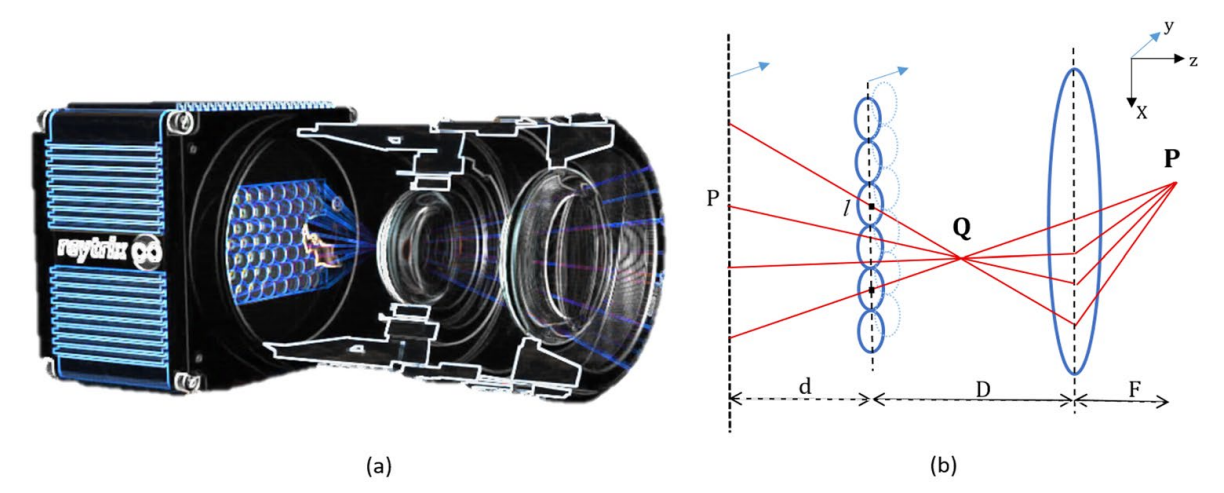

图2 全光相机。3D光场相机。b基于微透镜阵列的全光相机投影模型。

图2 全光相机。3D光场相机。b基于微透镜阵列的全光相机投影模型。

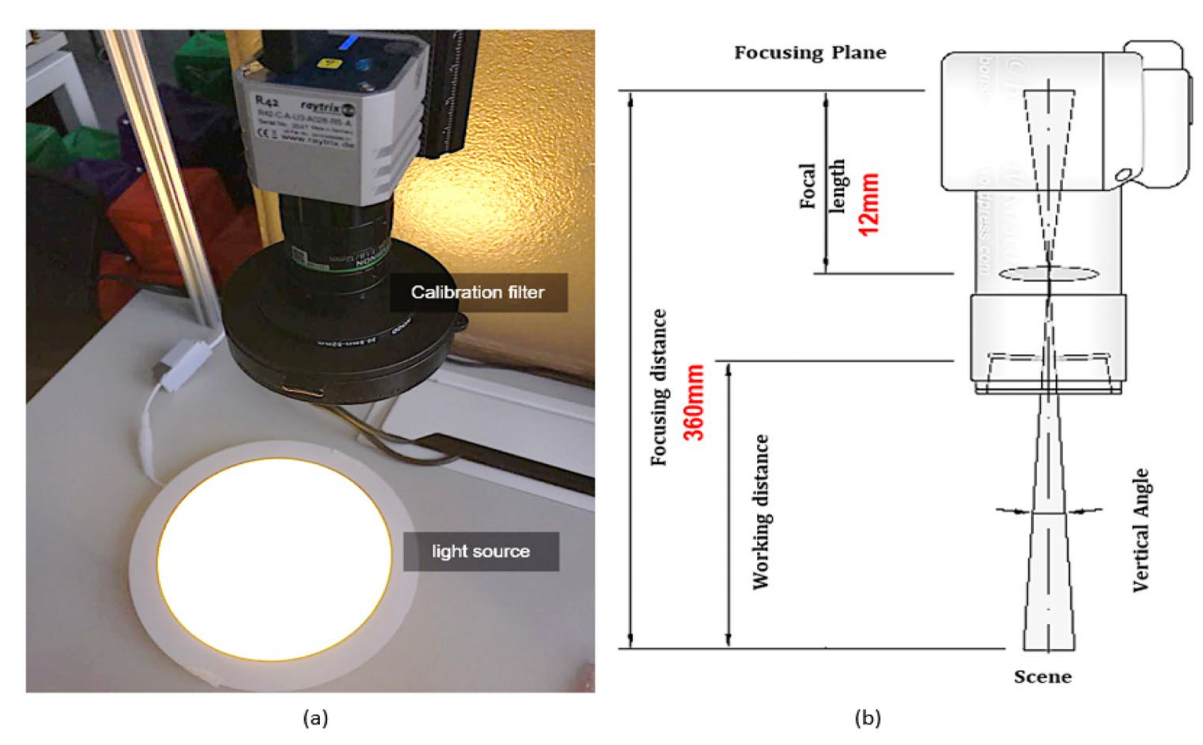

图3 带滤光片校准盘和光源的Ratrix R42相机。

图3 带滤光片校准盘和光源的Ratrix R42相机。

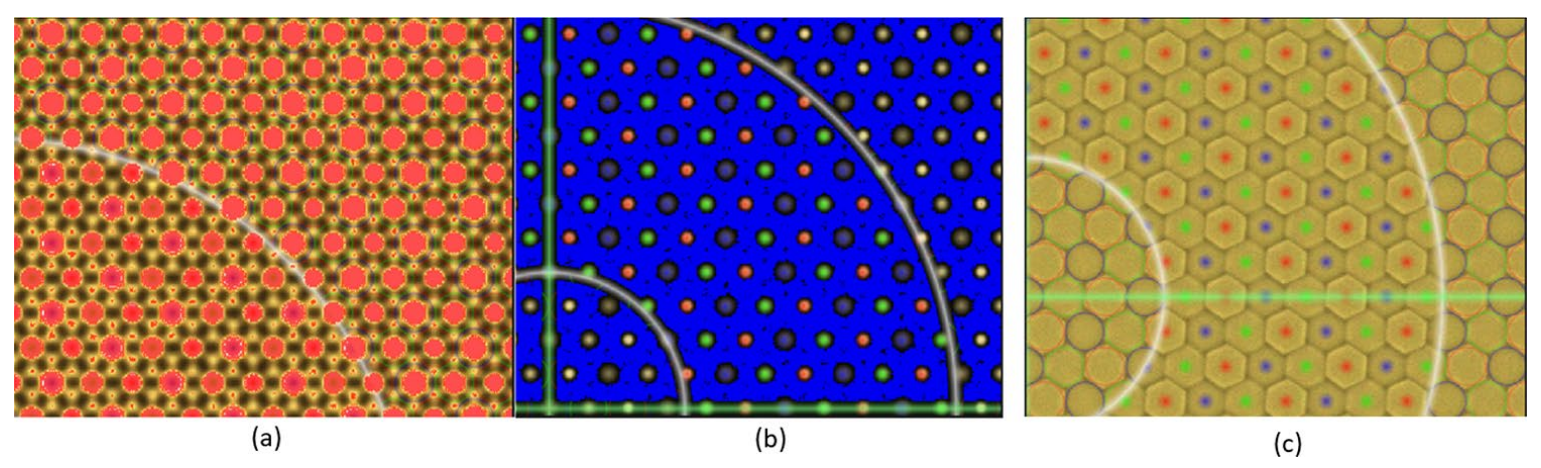

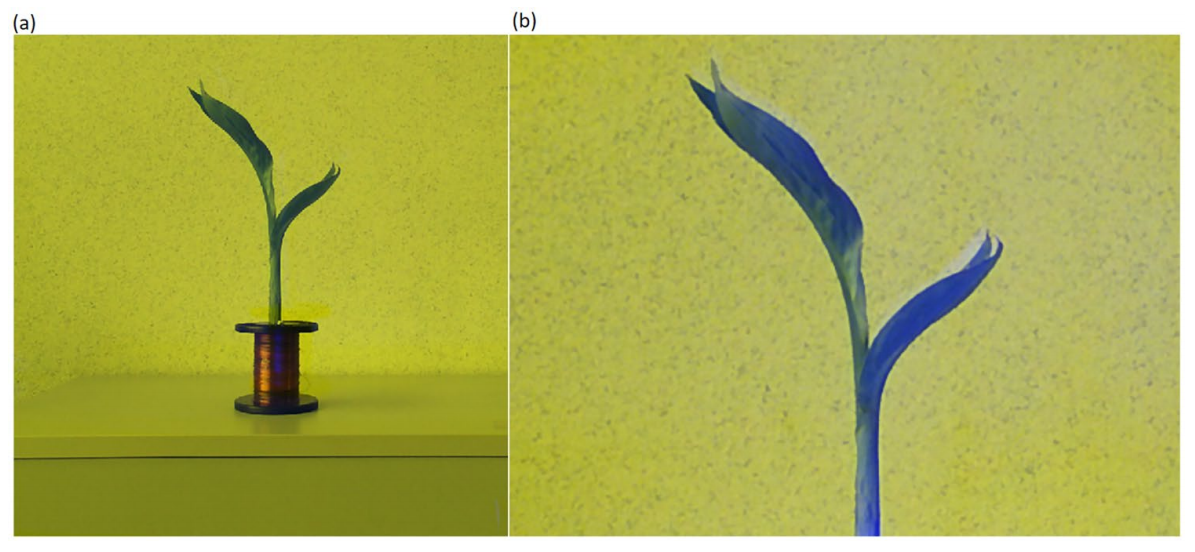

图4 a过度曝光的情况。b良好的照明条件。c微透镜阵列校准。

图4 a过度曝光的情况。b良好的照明条件。c微透镜阵列校准。

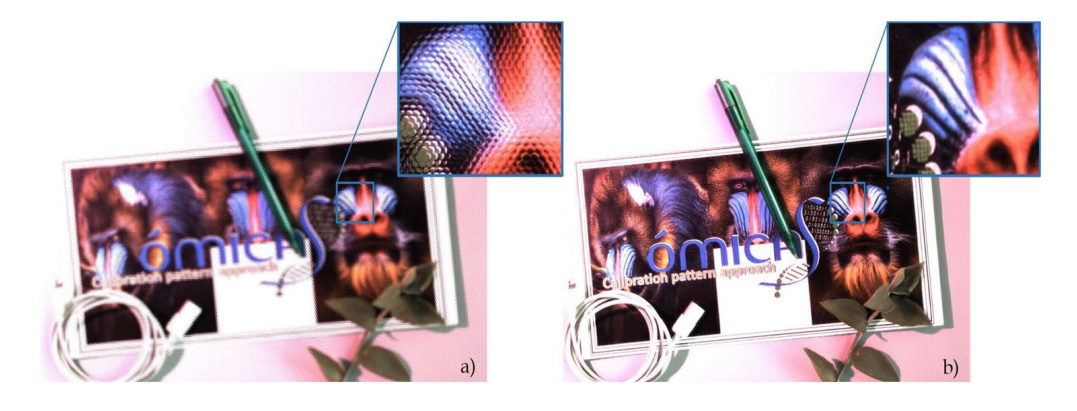

图5 a 用R42 Raytrix全光摄像机拍摄的光场图像,焦距为360 mm。b 用R42 Raytrix全光学摄像机拍摄的校准后光场图像。

图5 a 用R42 Raytrix全光摄像机拍摄的光场图像,焦距为360 mm。b 用R42 Raytrix全光学摄像机拍摄的校准后光场图像。

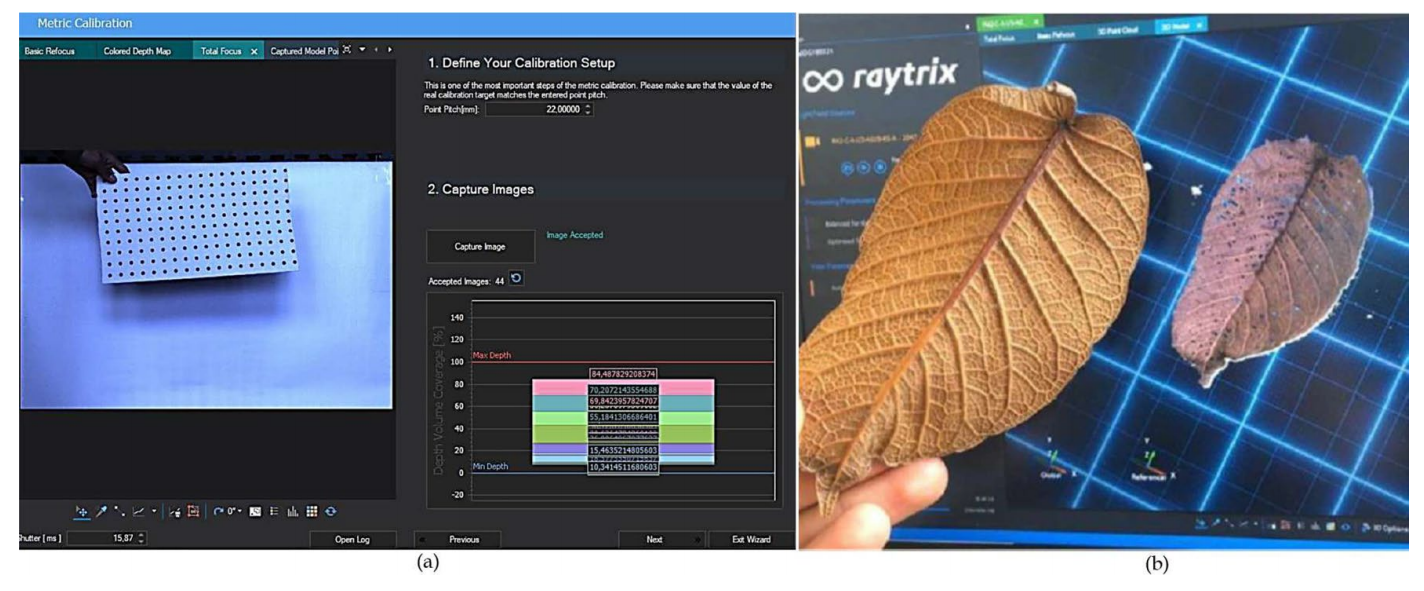

图6 a RxLive 5.0的公制校准接口。b 使用RxLive 5.0软件中的全光相机进行3D采集。

图6 a RxLive 5.0的公制校准接口。b 使用RxLive 5.0软件中的全光相机进行3D采集。

图7 目标检测方法。a图像采集。b模式识别阶段。c匹配-优化。d投影变换。

图7 目标检测方法。a图像采集。b模式识别阶段。c匹配-优化。d投影变换。

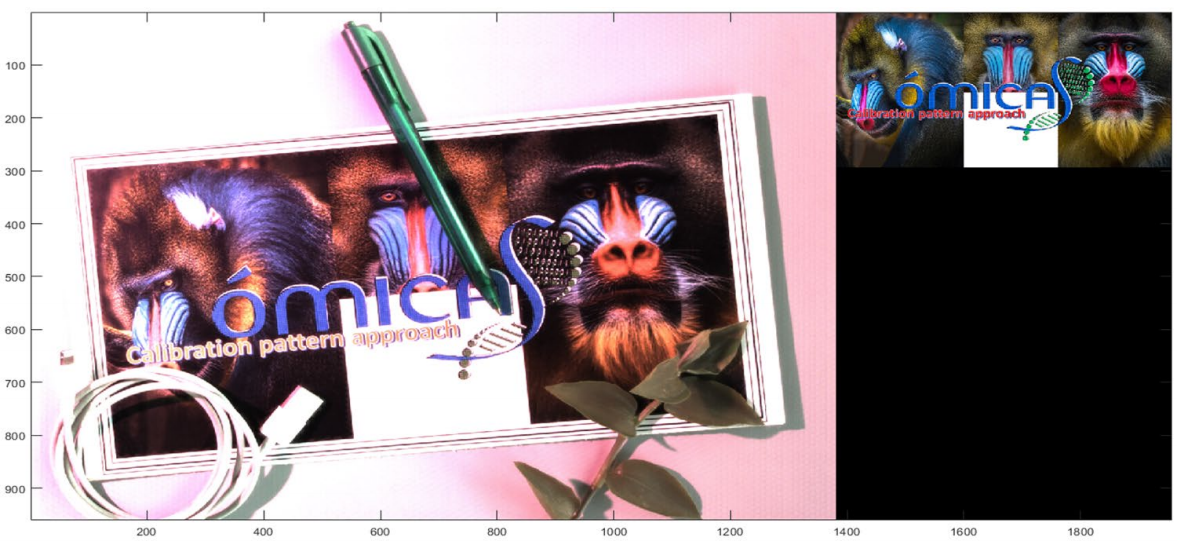

图8 实验设计的拓扑结构,右侧为感兴趣的对象,左侧为包含多个具有许多相似特征的对象的场景。

图8 实验设计的拓扑结构,右侧为感兴趣的对象,左侧为包含多个具有许多相似特征的对象的场景。

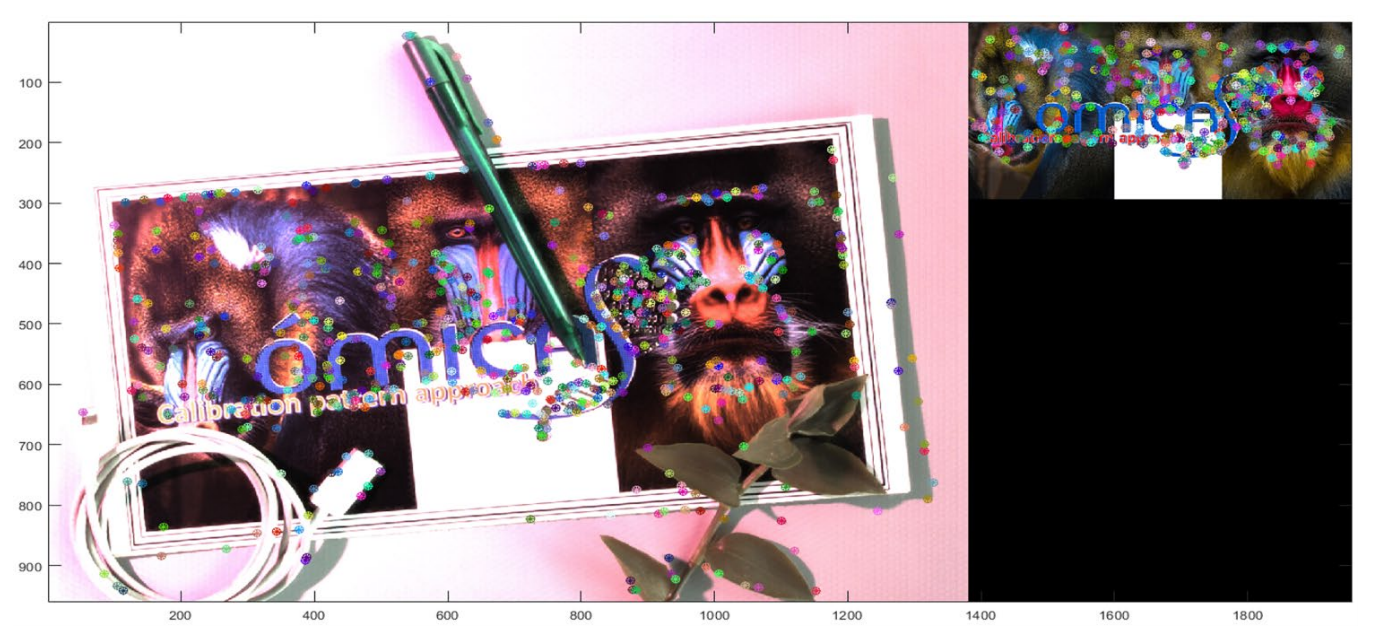

图9 图像的组成,用星号标记用SIFT算法为每个图像生成的描述符的位置。

图9 图像的组成,用星号标记用SIFT算法为每个图像生成的描述符的位置。

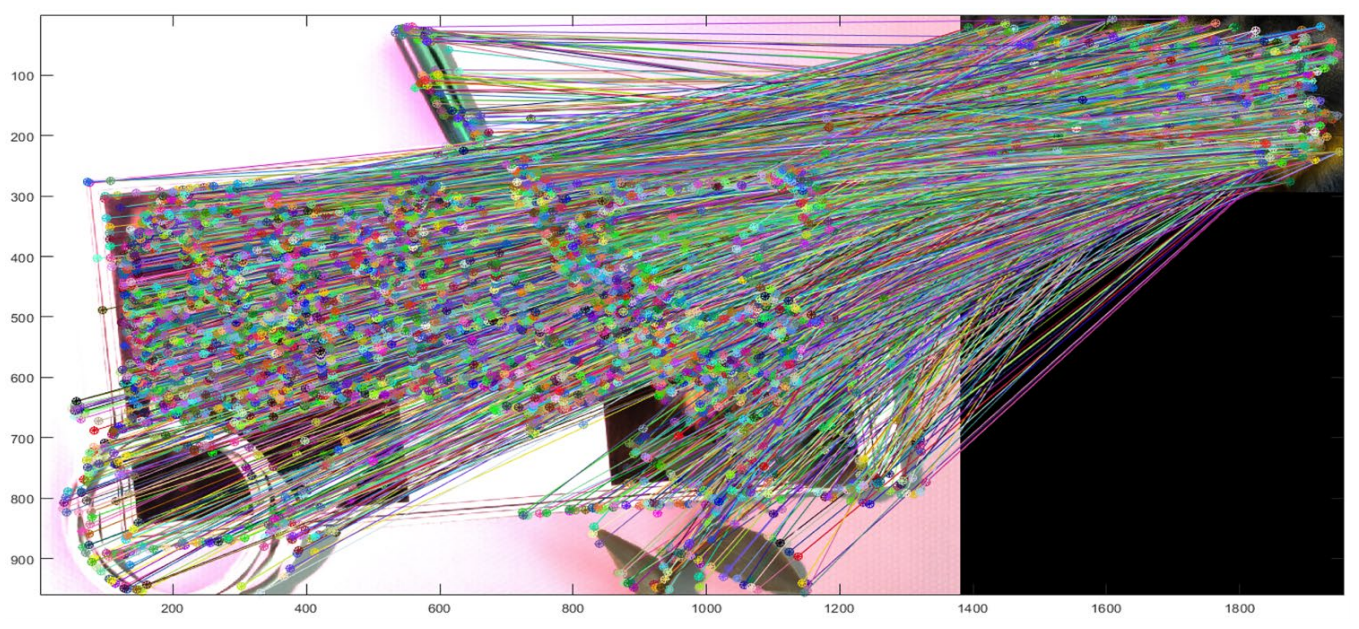

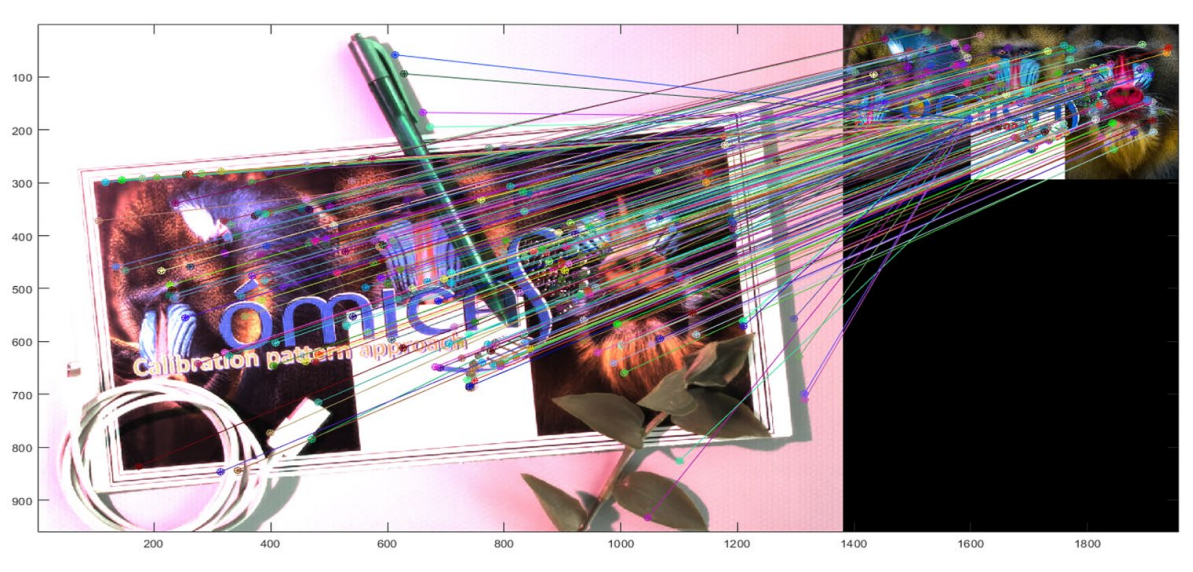

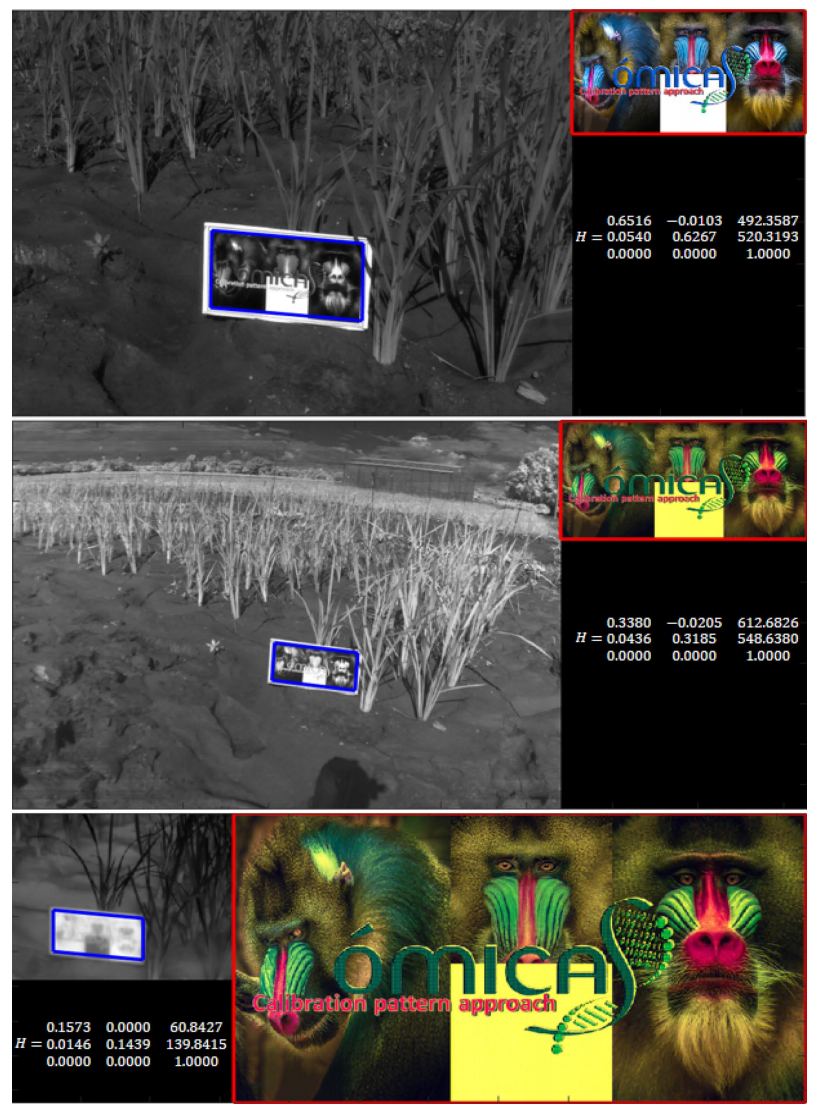

图10 7100个参考图像和场景图像之间的匹配。

图10 7100个参考图像和场景图像之间的匹配。

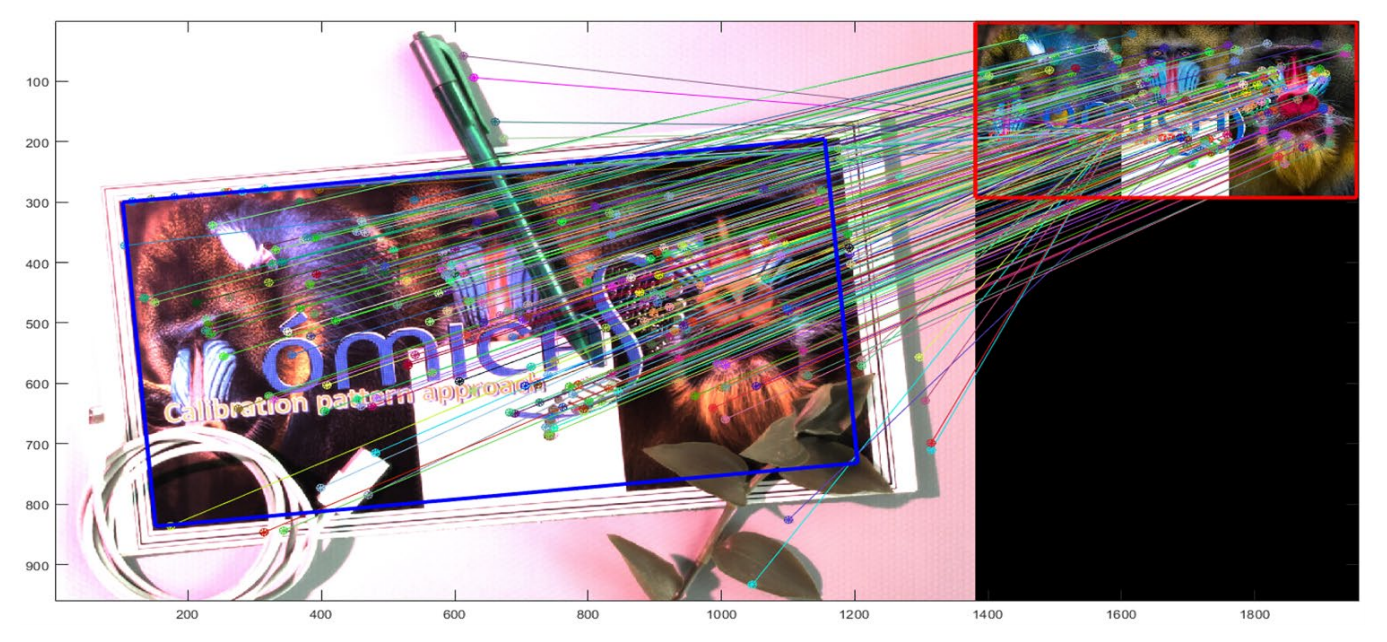

图11 使用算法1生成的251个匹配超过图10中的7100个匹配。

图11 使用算法1生成的251个匹配超过图10中的7100个匹配。

图12 受控条件下的遮挡物体识别。

图12 受控条件下的遮挡物体识别。

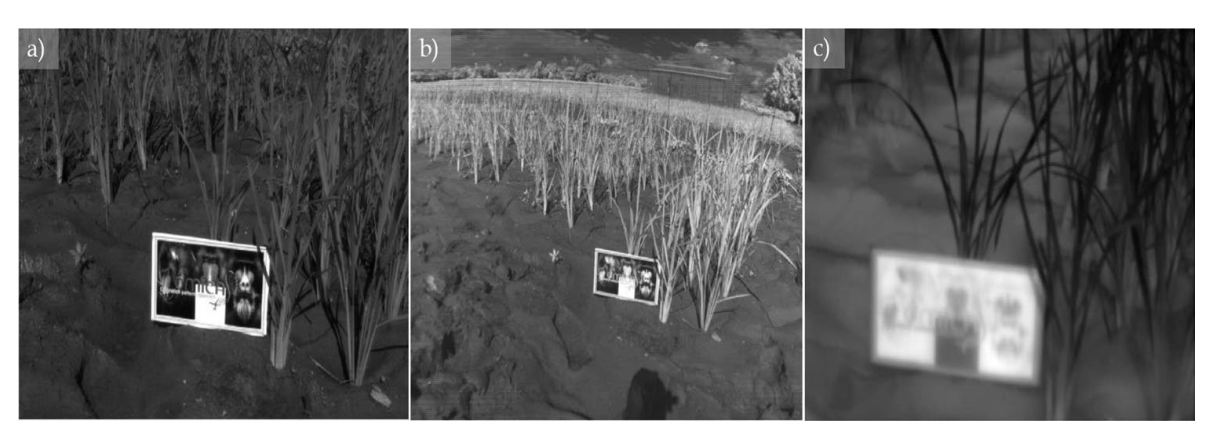

图13 田间条件下的植物图像采集,配备全光、多光谱和热像仪配置。

图13 田间条件下的植物图像采集,配备全光、多光谱和热像仪配置。

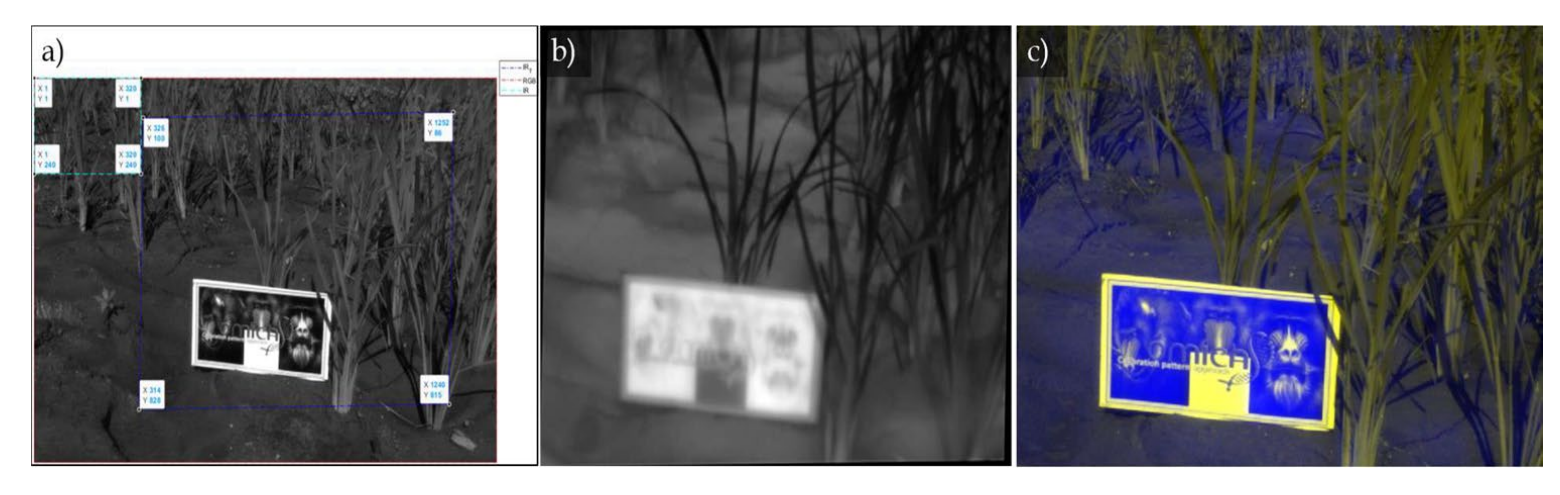

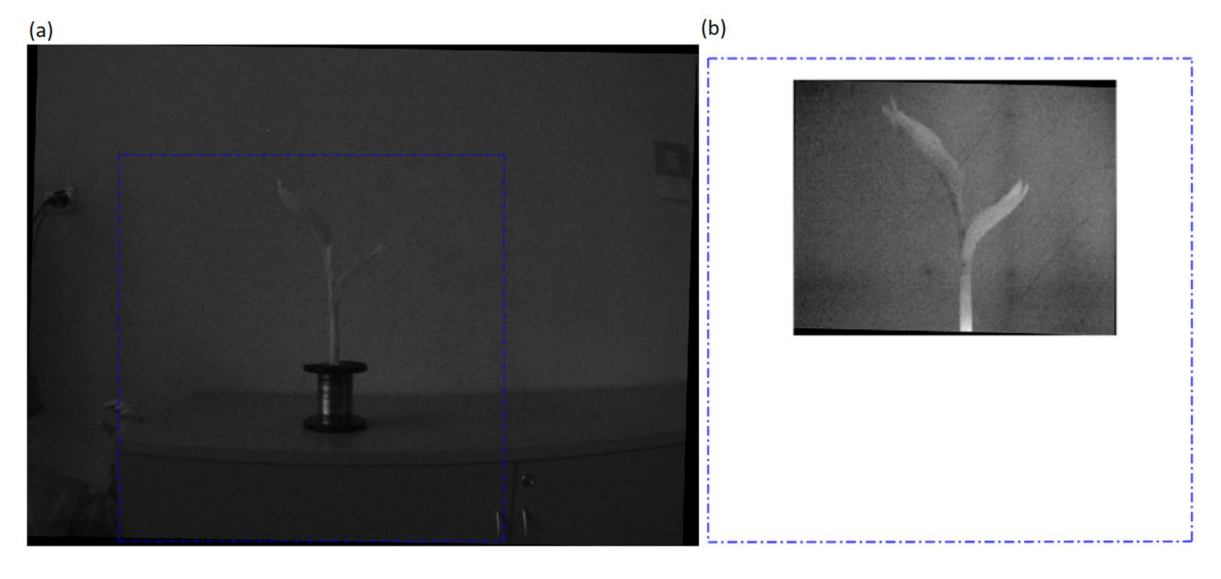

图14 一张带有raytrix R42相机的全光图像。分辨率=[960×1381]。bPARROT sequoia相机拍摄的红外图像。分辨率=[960×1280]。c热红外图像与t400 fluke相机。分辨率=[240×320]。

图14 一张带有raytrix R42相机的全光图像。分辨率=[960×1381]。bPARROT sequoia相机拍摄的红外图像。分辨率=[960×1280]。c热红外图像与t400 fluke相机。分辨率=[240×320]。

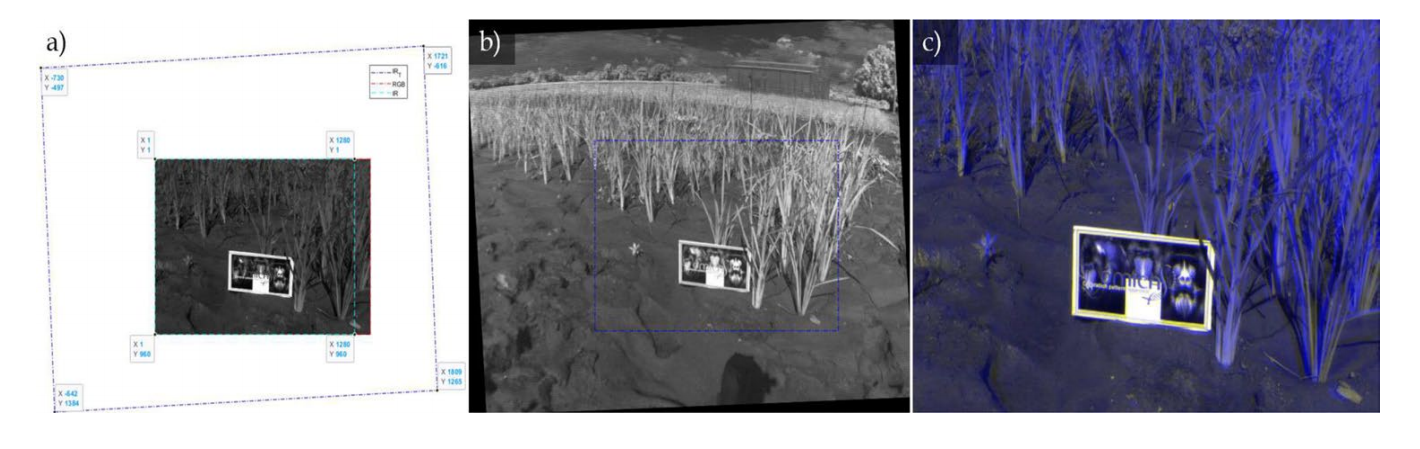

图15 全光相机和近红外多光谱相机之间的单色投影。b近红外多光谱图像的单色变换。c RGN图像。由全光图像的RG通道和多光谱相机的NIR通道组成。分辨率=[960×1381]。

图15 全光相机和近红外多光谱相机之间的单色投影。b近红外多光谱图像的单色变换。c RGN图像。由全光图像的RG通道和多光谱相机的NIR通道组成。分辨率=[960×1381]。

图16 全光相机和热多光谱相机MIR之间的单色投影。b热多光谱MIR图像的单色变换。c RGN2图像。由全光学图像的RG通道和热多光谱相机的MIR通道组成。分辨率=[716×915]。

图16 全光相机和热多光谱相机MIR之间的单色投影。b热多光谱MIR图像的单色变换。c RGN2图像。由全光学图像的RG通道和热多光谱相机的MIR通道组成。分辨率=[716×915]。

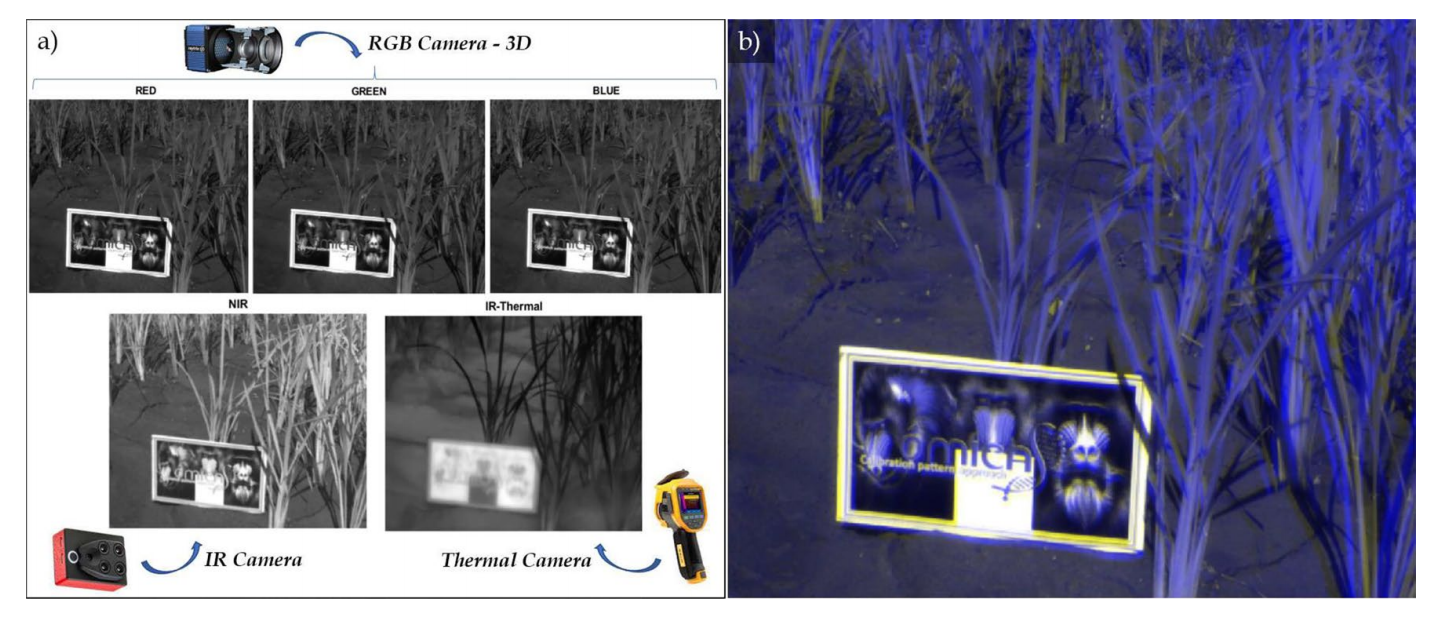

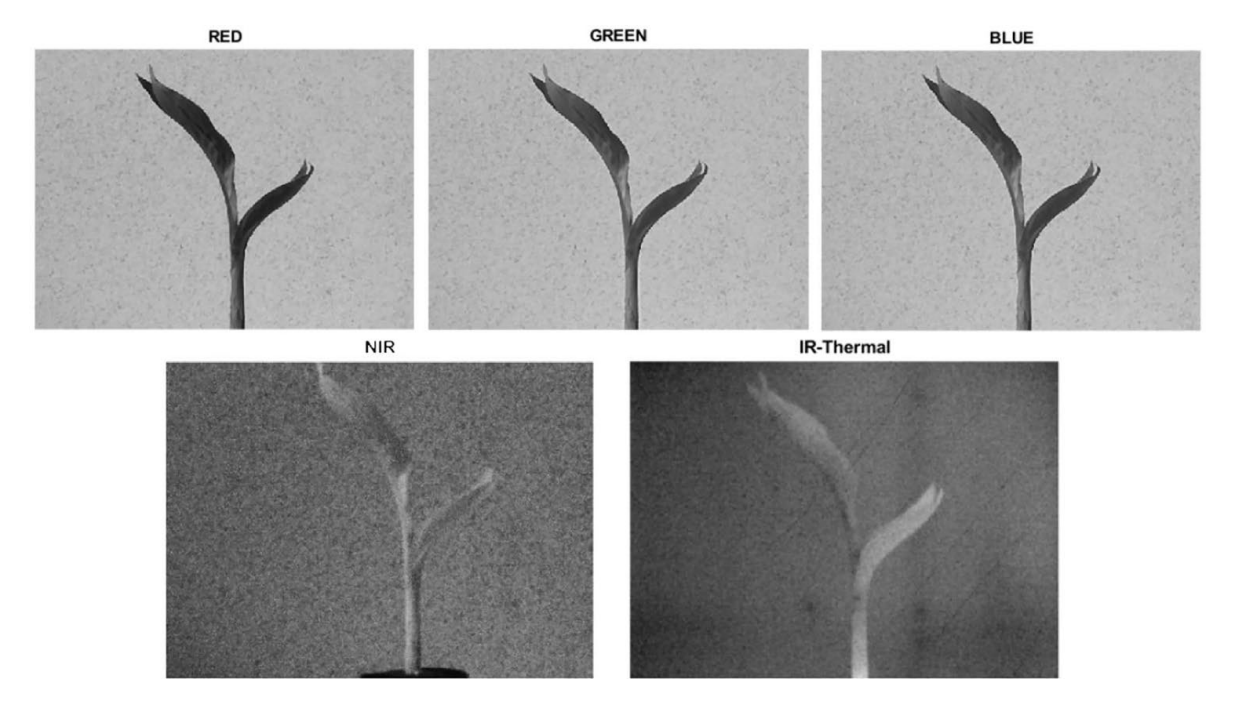

图17 a同一帧中的五个通道,来自全光相机的RGB、来自多光谱相机的NIR和来自热像仪的IR Thermal。分辨率=[960×1381].b RNN图像。由全光图像的R通道、近红外多光谱相机的IR通道和MIR热红外多光谱照相机的IR通道组成。分辨率=[716×915]。

图17 a同一帧中的五个通道,来自全光相机的RGB、来自多光谱相机的NIR和来自热像仪的IR Thermal。分辨率=[960×1381].b RNN图像。由全光图像的R通道、近红外多光谱相机的IR通道和MIR热红外多光谱照相机的IR通道组成。分辨率=[716×915]。

图18 通过复杂模式可视化形状和颜色变化的同源关系。

图18 通过复杂模式可视化形状和颜色变化的同源关系。

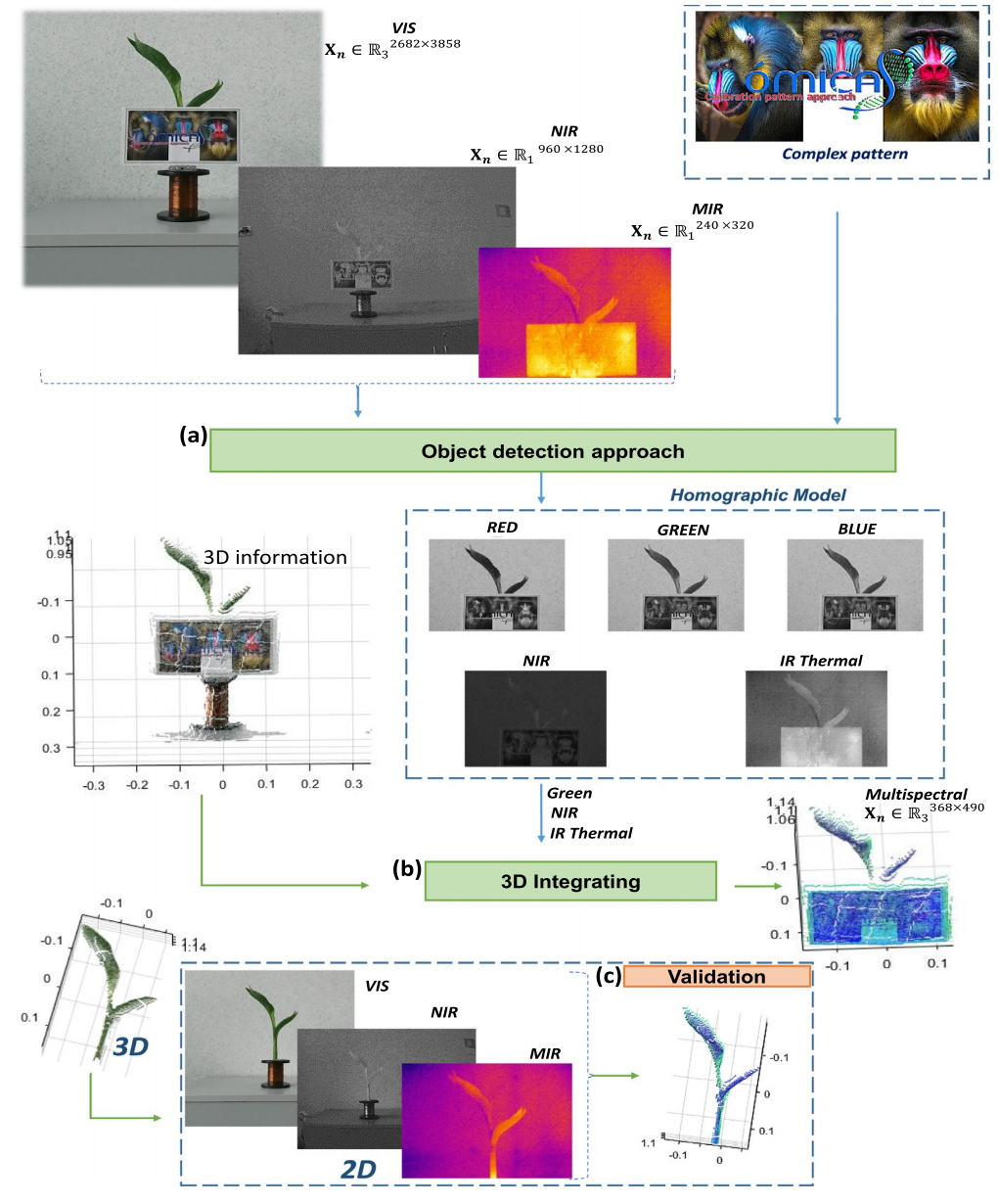

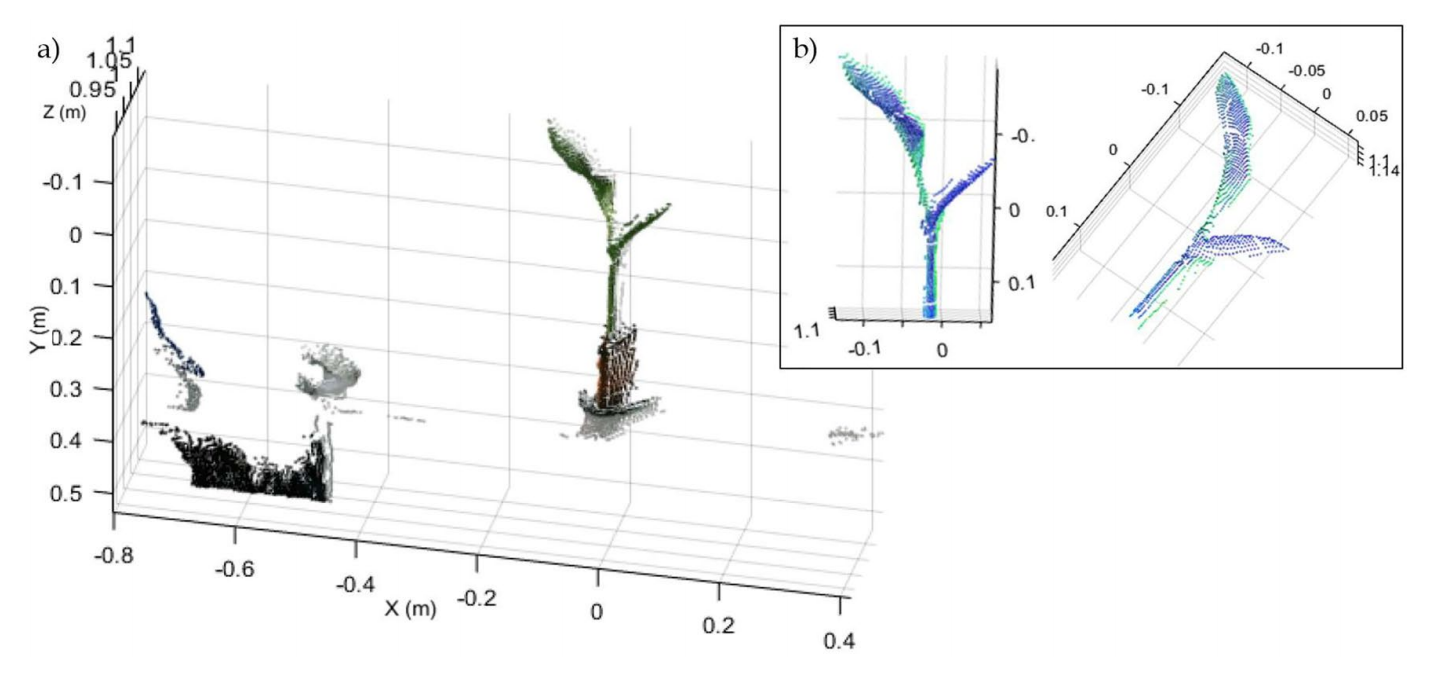

图19 传感器融合,从2D到3D。(a) 物体检测方法(b)三维集成(c)验证。

图19 传感器融合,从2D到3D。(a) 物体检测方法(b)三维集成(c)验证。

图20 同一帧中的五个通道,来自3D相机的RGB、来自多光谱相机的NIR和来自热像仪的IR Thermal。

图20 同一帧中的五个通道,来自3D相机的RGB、来自多光谱相机的NIR和来自热像仪的IR Thermal。

分辨率=[368×490]。

图21 RGB初始3D模型。使用Kinect v02传感器拍摄。b生成的3D模型,包括:(i)3D传感器的G通道,(ii)鹦鹉相机的IR通道和(iii)Fluke热像仪的红外热通道。

图21 RGB初始3D模型。使用Kinect v02传感器拍摄。b生成的3D模型,包括:(i)3D传感器的G通道,(ii)鹦鹉相机的IR通道和(iii)Fluke热像仪的红外热通道。

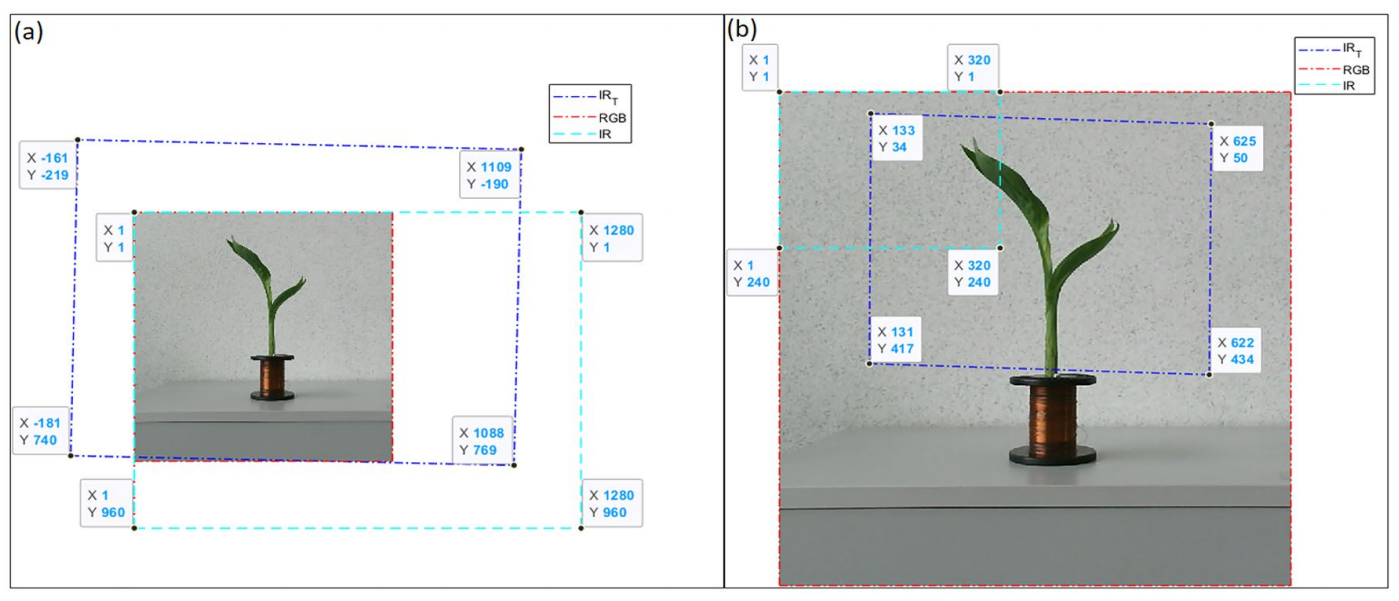

图22 Kinect相机和(a)近红外多光谱相机和(b)近红外热多光谱相机之间的单色投影。

图22 Kinect相机和(a)近红外多光谱相机和(b)近红外热多光谱相机之间的单色投影。

图23 (a)近红外多光谱图像和(b)MIR多光谱图像的同图变换。

图23 (a)近红外多光谱图像和(b)MIR多光谱图像的同图变换。

图24 (a) RGN图像,分辨率=[757×740]。(b) RGT图像,分辨率=[368×490]。

图24 (a) RGN图像,分辨率=[757×740]。(b) RGT图像,分辨率=[368×490]。

Correa, E.S., Calderon, F.C. & Colorado, J.D. A Novel Multi-camera Fusion Approach at Plant Scale: From 2D to 3D. SN COMPUT. SCI. 5, 582 (2024).

编辑

王春颖

推荐新闻

视频展示